Forschung

Artificial Voices in Human Choices

Wirkung sozialer Merkmale in der Mensch-Maschine-Kommunikation mit Blick auf das Marketing

Immer häufiger begegnet uns künstliche Sprache im Alltag: beim Autofahren mit Navigation, bei der Suche via Sprache im Internet oder beim Plausch mit Alexa, um nur ein paar Beispiele zu nennen. Dank neuester Fortschritte im Bereich der künstlichen Intelligenz klingen die künstlichen Stimmen auch immer natürlicher. Die Stimme ist ein mächtiger Informationsträger. Neben dem Inhalt verrät der Ton viel über persönliche und soziale Merkmale wie z.B. Geschlecht, Persönlichkeit, Identität und Emotion. Die Interpretation dieser Merkmale ist essenziell in der zwischenmenschlichen Interaktion und hat einen großen Einfluss auf Verhalten und Entscheidungen. Doch wie sieht es mit der sprachlichen Interaktion zwischen Mensch und Maschine aus? Ziel des Forschungsprojekts ist es, den Einfluss des Tonfalls künstlicher Stimmen auf Konsumentscheidungen zu untersuchen. Mithilfe neuester Deep-Learning-Verfahren aus dem Bereich der künstlichen Intelligenz generieren wir zunächst künstliche Stimmen mit bestimmtem Tonfall und testen anschließend den Einfluss auf Konsumentscheidungen in verschiedenen Experimenten.

Teilprojekt 1: Emotionen in der Mensch-Maschine-Kommunikation

Ein wichtiges soziales Merkmal der menschlichen Stimme ist die Emotion. Emotionen wirken in der Mensch-Mensch-Interaktion häufig ansteckend. Durch die Nachahmung von Mimik, Gestik und Stimme fühlen sich Menschen in die Stimmung des Gesprächspartners ein. Doch funktioniert das Phänomen der Gefühlsansteckung auch in der Mensch-Maschine-Kommunikation? Und welche Wirkung hat das ggf. auf menschliches Verhalten? Aus Marketingsicht stellt sich z.B. die Frage: Kann ein begeistert klingender Sprachassistent einen Konsumenten vom Produkt begeistern und zu einem Impulskauf animieren? Zu diesem Zweck haben wir ein Deep Learning Model entwickelt, das in der Lage ist, künstliche Sprache mit unterschiedlichen Emotionen zu generieren. Das macht es uns möglich, den Einfluss von synthetischen Stimmen auf das Kaufverhalten in Laborexperimenten zu testen.

Teilprojekt 2: bekannte Stimmen in der Mensch-Maschine-Kommunikation

Neue Verfahren des Deep Learning ermöglichen es, künstliche Sprache in einem Tonfall zu erzeugen, der sie wie die Stimmen von bestimmten Personen klingen lässt. Amazon bietet zum Beispiel seinen Alexa-Kunden in den USA an, Samuel L. Jackson als Ausgabestimme zu wählen, und weitere prominente Stimmen sind geplant. Für das Marketing eröffnet diese Technologie sowohl neue Potenziale (z.B. Präsentation personalisierter Inhalte in der Stimme eines Lieblingsstars) als auch neue Risiken (z.B. Veröffentlichung von Fake News in der Stimme eines wichtigen Entscheidungsträgers).

In unserer Forschung beschäftigen wir uns deshalb mit der Frage, wie künstliche Stimmen im Tonfall bekannter Personen auf Konsumenten wirken und inwiefern Aufklärung über die Möglichkeiten moderner Sprachsynthese die Wirkung beeinflussen und so zum Beispiel Fake Voice News entgegenwirken kann. Bestehende Forschung im Bereich Human-Computer-Interaction hat gezeigt, dass Personen künstlichen Stimmen gedanklich eine Persönlichkeit zuordnen und mehrere künstliche Stimmen als glaubhafter empfinden als eine künstliche Stimme – auch wenn man sie darauf hinweist, dass es sich um künstlich generierte Stimmen handelt. Es stellt sich daher für uns die Forschungsfrage, ob dies auch bei bekannten künstlich generierten Stimmen der Fall ist.

Studie: Emotionale Sprachassistenten beim Shopping

Sprachassistenten boomen: Die intelligenten Lautsprecher von Amazon, Google und anderen Anbietern ziehen immer häufiger in unsere Haushalte ein und viele ihrer Besitzer übertragen ihnen bereits Alltagsaufgaben, lassen sich bspw. Musik oder Produkte vorschlagen und können sich vorstellen, in naher Zukunft manche ihrer regelmäßigen Einkäufe durch einen Voice Assistant organisieren zu lassen. Allerdings wünschen sich die Besitzer mehr Emotionalität, Fröhlichkeit oder Abwechslung in der Stimme ihres Sprachassistenten – wie eine andere Studie des NIM zeigt.

Für das Marketing ist es daher essenziell, sich mit der wachsenden Bedeutung von digitalen Sprachassistenten auseinanderzusetzen. Inwieweit die Geräte als Verkaufskanal die Machtverhältnisse zwischen Konsumenten, Händlern und Herstellern verschieben werden, ist zwar noch offen – aber mit Emotionalität in der Stimme sind Sprachassistenten im Kernbereich von Kaufentscheidungen angekommen. Denn dass Emotionen in der Mensch-Mensch-Interaktion – beispielsweise ausgelöst durch Stimme – ansteckend sind und das Kaufverhalten beeinflussen, ist seit Jahren umfassend belegt. So neigen zum Beispiel emotional erregte Kunden eher zu Impulskäufen.

Da es eines der Ziele des Nürnberg Institut für Marktentscheidungen ist, zu untersuchen, welchen Einfluss Trends und neue Technologien auf das Entscheidungsverhalten von Verbrauchern haben, haben wir im November 2019 untersucht, ob und wie sich die Tonlage von Sprachassistenten auf das Kaufverhalten von Konsumenten auswirkt. An der Studie „Artificial Voices in Human Choices – The Impact of Synthesized Speech with Emotional Tone on Consumer Behavior“ nahmen 213 Studierende der Friedrich-Alexander-Universität Erlangen-Nürnberg teil.

Die Studie

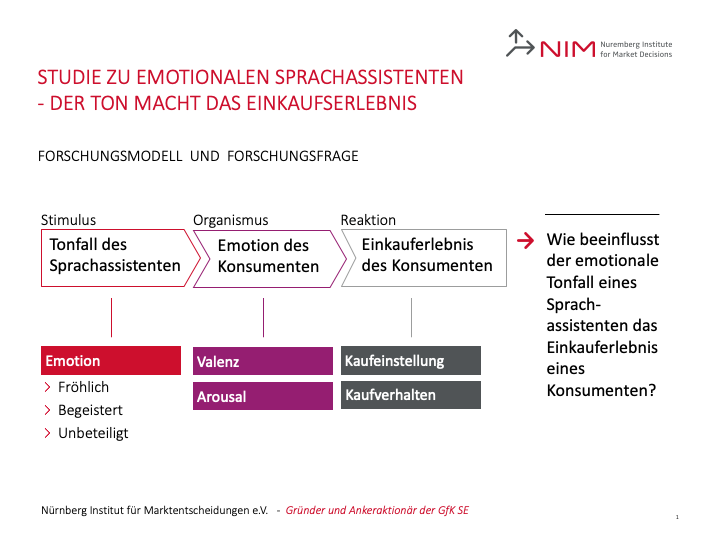

Um belastbare Daten für das noch wenig erforschte Gebiet zu erhalten, war ein mehrstufiges Vorgehensmodell notwendig, das sich an dem wissenschaftlich etablierten Stimulus-Organismus-Reaktionsmodell orientierte. Als Stimulus dienten emotionale Stimmen von Sprachassistenten, die von diesen erst erlernt werden mussten. Anschließend wurden die Emotionen der Versuchsteilnehmer in den Dimensionen Valenz (positiv vs. negativ) und Arousal (ruhig vs. emotional erregt) gemessen. Danach wurde in einem Shopping-Experiment die konkrete Reaktion auf den Stimulus – mittels Beobachtung des Kaufverhaltens und der Abfrage von Kaufeinstellungen – ermittelt.

Der Ton macht den Einkauf zum Erlebnis

In der Ausgabe 2/2020 der Zeitschrift planung&analyse ist ein ausführlicher Artikel zu unserer Studie erschienen:

Auf die Emotion in der Stimme des Sprachassistenten kommt es beim Einkauf an.

Kommunikation zwischen Menschen und Computern findet immer häufiger über Stimme statt. Aus der Forschung ist bekannt, dass die Emotion in der Stimme den Verkaufsprozess entscheidend beeinflussen kann. Doch gilt das auch für die synthetische Stimme von Voice Assistants? Dr. Carolin Kaiser und René Schallner vom Nürnberg Institut für Marktentscheidungen (NIM) wollten dies herausfinden und stellen fest: Auf die Emotion in der Stimme des Sprachassistenten kommt es an.

Synthetische Stimmen

Hier hören Sie synthetische Stimmen, die Dr. Carolin Kaiser und René Schallner im Rahmen ihres Forschungsprojekts Artificial Voices In Human Choices entwickelt haben.

Projektteam

- Dr. Carolin Kaiser, Head of Artificial Intelligence, NIM, carolin.kaiser@nim.org

- René Schallner

Publikationen

- Kaiser, C., & Schallner, R. (2022). The impact of emotional voice assistants on consumers’ shopping attitude and behavior. Wirtschaftsinformatik 2022 Proceedings, Nuremberg, Germany. https://aisel.aisnet.org/wi2022/workshops/workshops/10

- Kaiser, C., & Schallner, R. (2020). Artificial Voices in Human Choices. Proceedings of the 22nd General Online Research Conference, Berlin, Germany. https://www.gor.de/wp-content/uploads/2020/02/GOR20_Conference-Proceedings_Web.pdf

Kontakt