Forschung

Fair ist nicht gleich fair – Interaktion zwischen Mensch und Maschine

Digitale (Sprach-)Assistenten wie Cortana, Alexa oder Siri werden immer mehr Teil unseres täglichen Lebens. Auch in Entscheidungssituationen, z.B. bei Konsum- oder Investitionsentscheidungen, machen künstliche Agenten Vorschläge und versuchen so, den Menschen bei der Entscheidungsfindung zu unterstützen. Zusätzlich arbeiten Entwickler daran, diese Assistenten immer menschenähnlicher zu machen, indem sie ihnen Namen und eine Stimme geben oder sie menschliches Verhalten wie den Gebrauch natürlicher Sprache oder Empathie nachahmen lassen.

Bei Interaktionen mit anderen Menschen, z.B. bei Verhandlungen oder wirtschaftlichen Transaktionen, spielen soziale Normen und Präferenzen eine wichtige Rolle. Aber ist dies auch bei der Interaktion mit Maschinen der Fall? In einer Welt mit einer wachsenden Zahl anonymer und automatisierter wirtschaftlicher Interaktionen und Transaktionen wird dies immer wichtiger.

In Laborexperimenten untersuchen wir, wie sich Entscheidungen verändern, wenn man mit Computeragenten wie z.B. intelligenten Systemen zur Entscheidungsunterstützung oder sogenannten Conversational Agents anstelle von Menschen interagiert, und welche Auswirkungen Systeme mit menschlichen Merkmalen (z.B. einer Stimme, einem Namen, einem menschlichen Aussehen oder sogar einer Persönlichkeit) haben können.

In einem ersten Projekt untersuchen wir grundlegend den Einfluss menschlicher Charakteristika auf das Entscheidungsverhalten in sozialen Interaktionen mit sprachbasierten Computeragenten.

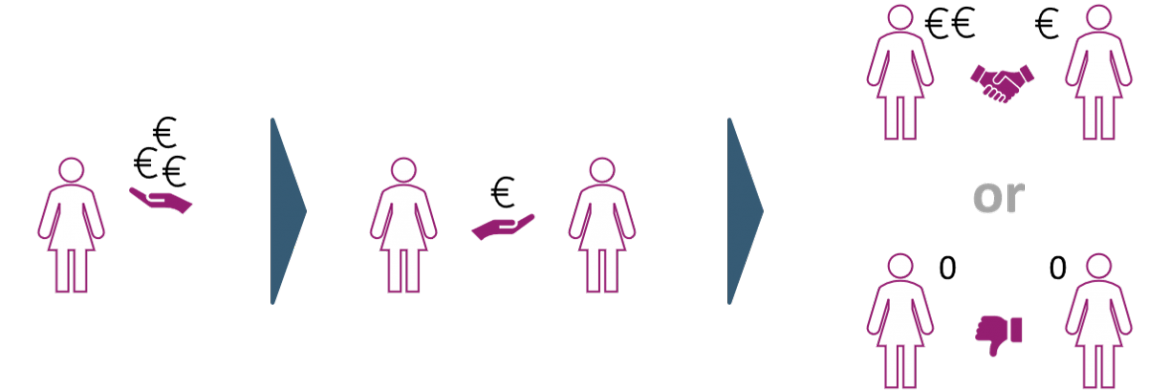

Beim sogenannten Ultimatum-Spiel kann eine Person einen Geldbetrag zwischen sich und einer anderen Person aufteilen. Nimmt die andere Person diese Aufteilung an, werden beide entsprechend belohnt. Wenn das Angebot abgelehnt wird, erhalten beide nichts. Mit diesem Spiel haben wir untersucht, ob sich das Annahmeverhalten bei unfairen Angeboten ändert, wenn das Angebot i) von einem Computeragenten statt von einer anderen menschlichen Person gemacht wird und ii) per Sprachnachricht statt der Standardmethode, einer Textnachricht, übermittelt wird.

In einem zweiten Projekt erweitern wir unser Setting, indem wir dem Computeragenten zusätzlich ein menschliches Aussehen in der virtuellen Realität geben.

Mit diesem Projekt schaffen wir ein grundlegendes Verständnis dafür, wie Menschen in sozialen Interaktionen mit menschenähnlichen Computeragenten Entscheidungen treffen. Die Ergebnisse liefern Implikationen für wirtschaftliche Entscheidungssituationen, in denen Verbraucher mit KI-basierten intelligenten Maschinen interagieren, wie z.B. Chatbots als erster Touchpoint in der Customer Journey oder KI-basierte Sprachassistenten in Callcentern bei Beschwerden über Produkte oder Dienstleistungen.

Die wichtigsten Ergebnisse:

- Menschen akzeptieren unfaire Angebote von Maschinen wahrscheinlicher als von Menschen.

- Allerdings führen menschliche Charakteristika bei Maschinen dazu, dass unfaire Angebote tendenziell abgelehnt werden.

- Dies ist vor allem bei menschlichem Aussehen (Avatar in der VR) zu beobachten.

- Der Effekt der Stimme ist tendenziell schwach und muss weiter untersucht werden.

Projektteam

- Dr. Matthias Unfried, Head of Behavioral Science, NIM, matthias.unfried@nim.org

- Dr. Michael K. Zürn, Senior Researcher, NIM, michael.zuern@nim.org

Kooperationspartner

- Prof. Alessandro Innocenti, Universität Siena, Italien

Kontakt

![[Translate to English:] [Translate to English:]](/fileadmin/_processed_/1/2/csm_CK_NIM_01_58bed63910.png)